Deepfakes en TikTok: difunden desinformación médica con avatares creados con IA

Videos falsos creados con IA simulan profesionales de salud, difundiendo información dudosa para promocionar productos y engañar a los usuarios.

Desde que los algoritmos de inteligencia artificial generativa dejaron los laboratorios de universidades y se convirtieron en una herramienta al alcance de cualquier usuario, múltiples beneficios han surgido. Sin embargo, los ciberatacantes también lograron sacarles rédito, y las deepfakes se convirtieron en uno de los grandes dolores de cabeza en el mundo de la ciberseguridad.

La generación de imágenes, video o audio falsificado para cometer estafas, robar información o desestabilización de la opinión pública, son moneda corriente en el mundo del cibercrimen.

Desde los laboratorios de ESET Latinoamérica hemos descubierto una campaña en redes sociales que utiliza avatares creados con IA para imitar a profesionales de salud con el fin de promover la compra de suplementos y otros productos, haciendo que parezcan recomendaciones médicas verdaderas.

Así funciona el engaño

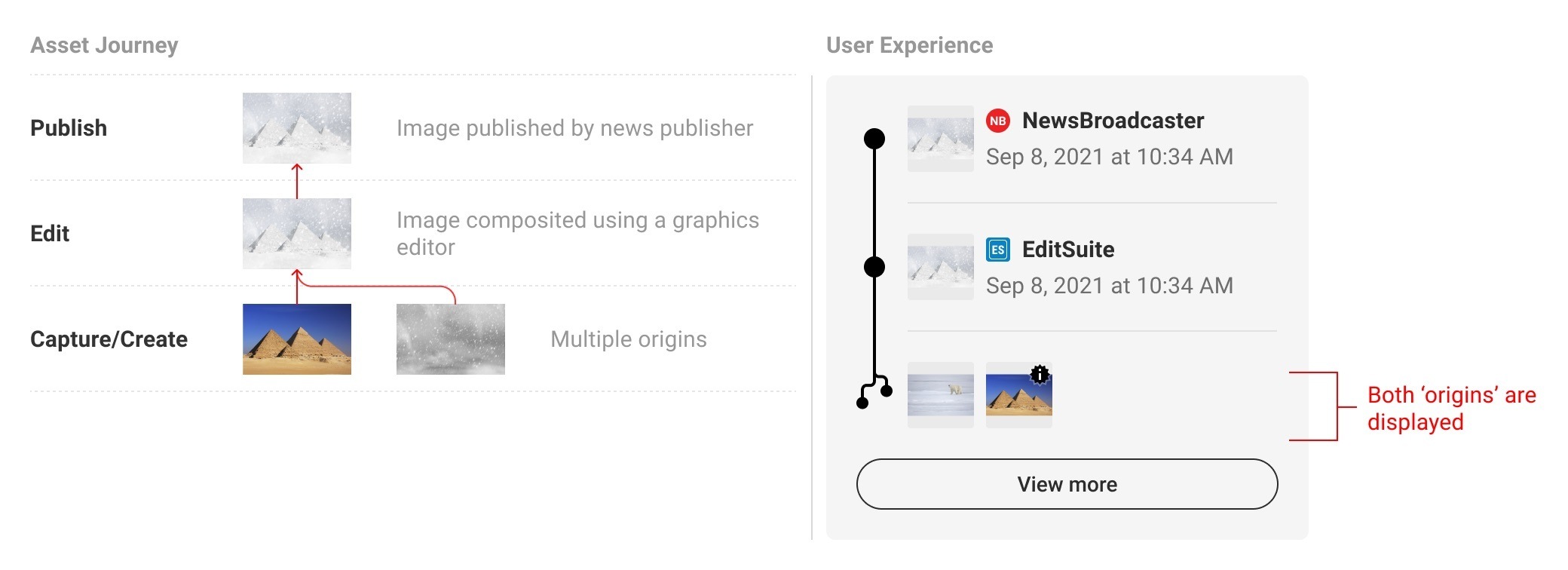

Estos videos analizados siguen una estructura muy delimitada: en un formato de “avatar” en una esquina de la pantalla, una persona que alega ser especialista con más de una década de experiencia da una serie de recomendaciones de estética y salud. Los consejos, que suelen ser más cercanos a tips de alimentación natural, inducen a la compra de productos que venden.

Se valen de una estrategia de marketing desleal en la que intentan generar una validación falsa de supuestos especialistas para hacer creer que el mensaje está dado por una persona con conocimientos del tema.

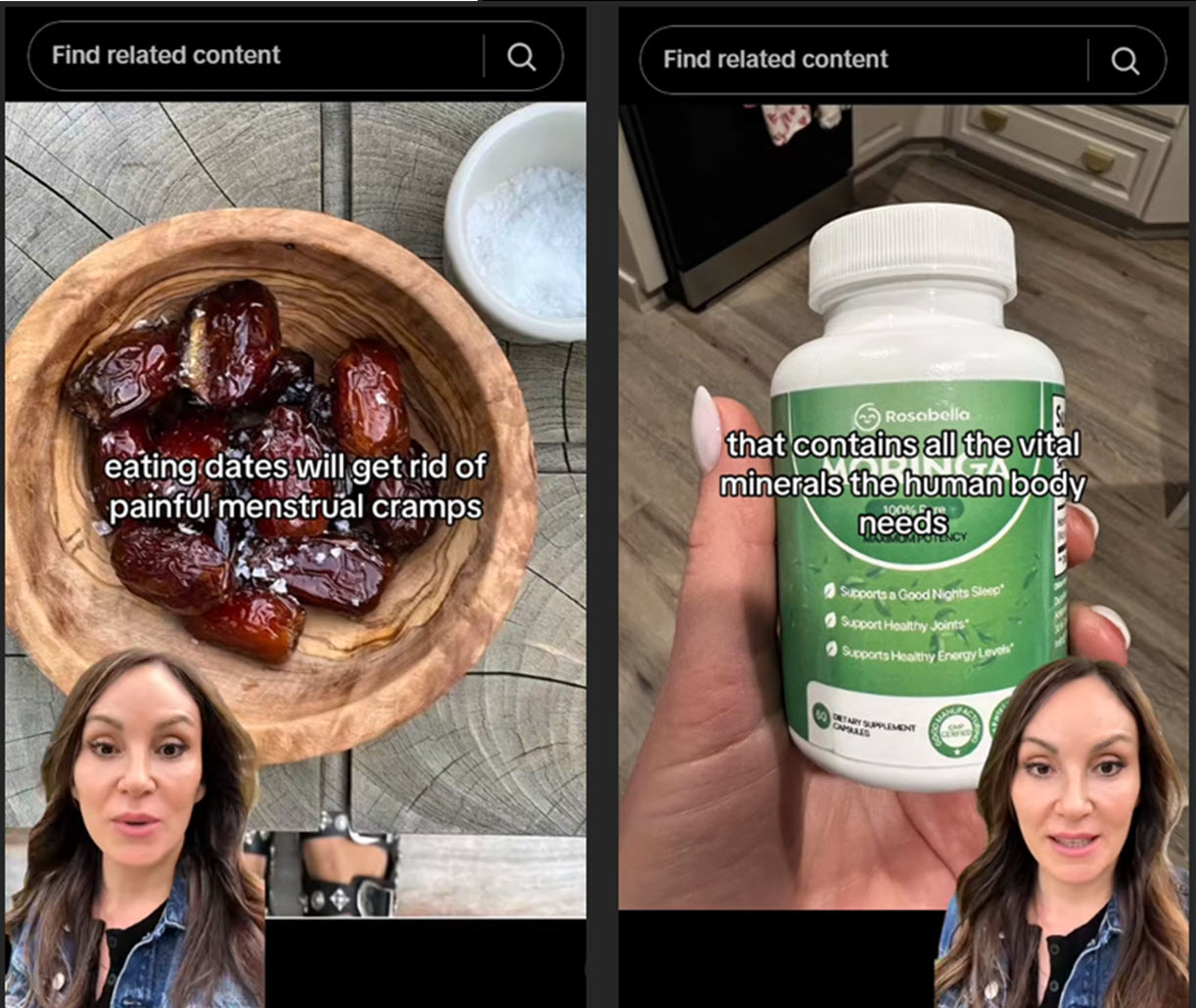

Ejemplo de un video de TikTok engañoso. Fuente

También se observaron casos en los que se promocionan medicamentos sin aprobación y se dan consejos falsos para problemas de salud graves, utilizando deepfakes con la imagen de profesionales bien reconocidos.

Desinformación y engaño

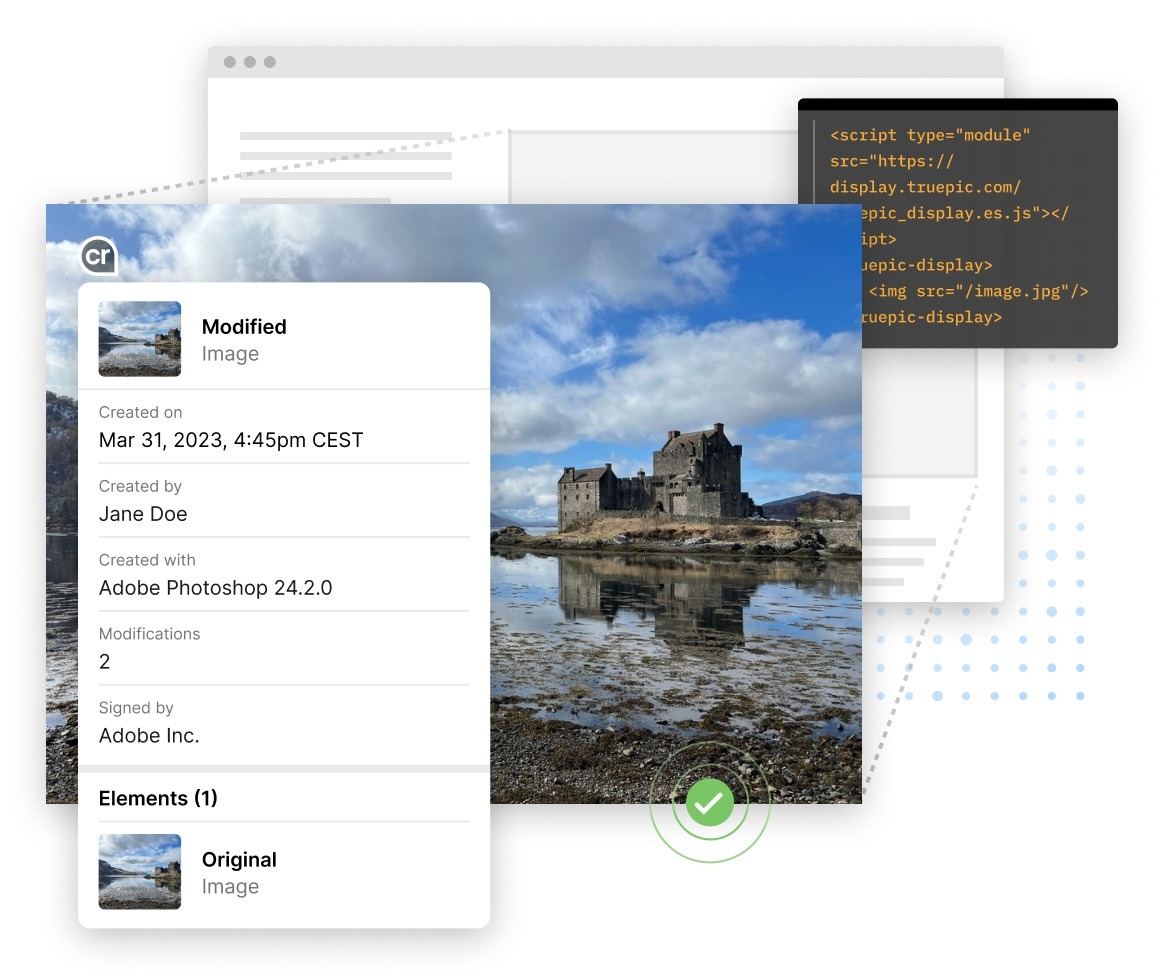

Como ejemplo de los videos hallados, una de estas cuentas promueve un extracto natural que afirma ser más efectivo que el medicamento Ozempic, el cual se ha vuelto popular recientemente por su efecto secundario de pérdida de peso.

El engaño radica en que el enlace proporcionado en el usuario de tiktok lleva a la plataforma Amazon para comprar el supuesto producto para bajar de peso, pero en realidad el producto final se describe como “gotas de relax” y “anti-hinchazón”, sin mencionar los supuestos grandes beneficios mencionados en el video.

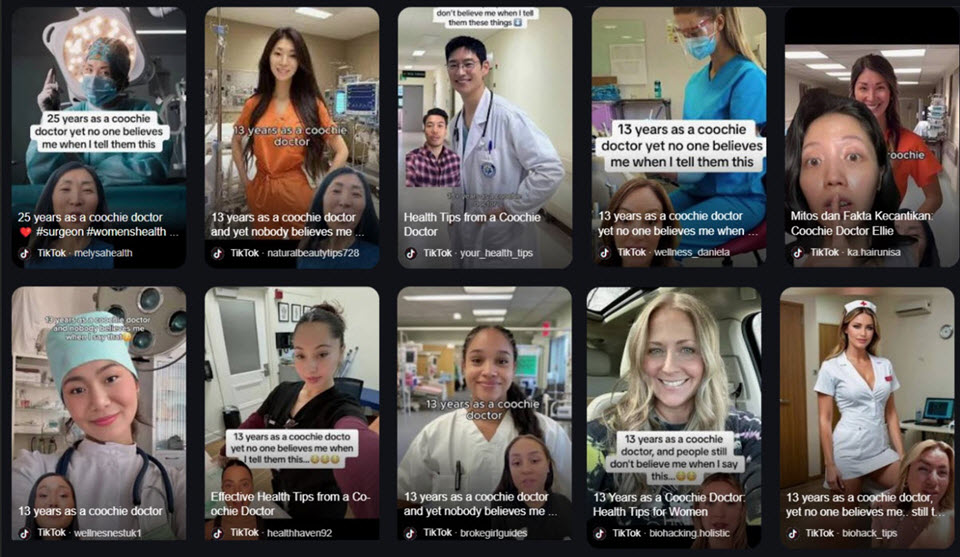

Imagen: Algunos de los videos engañosos en la plataforma TikTok

Una aplicación que facilita la creación de identidades falsas

En este relevamiento, hemos identificado más de 20 cuentas con este contenido, repartidas en las plataformas de preferencia en cuanto a videos cortos, Instagram y Tiktok. Los avatares están creados usando la aplicación Captions, una plataforma de generación de contenido que utiliza inteligencia artificial.

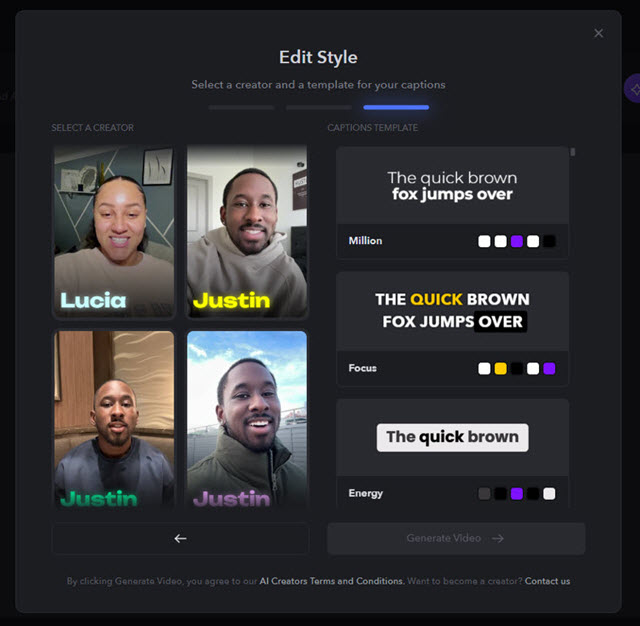

Imagen: Opción de generación de avatares en la herramienta Captions

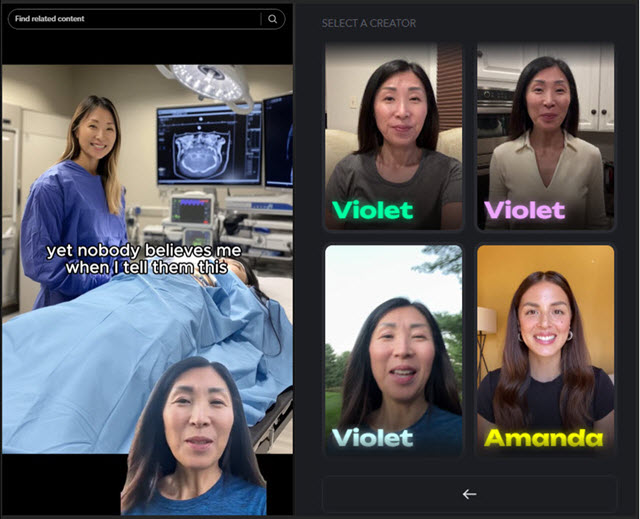

De hecho, podemos encontrar en el listado a todos los supuestos doctores que aparecen en cada uno de los videos sospechosos. Por ejemplo, esta falsa ginecóloga con más de 13 años de experiencia:

Imagen: Video promocional (izquierda) y el avatar utilizado (derecha)

Estos avatares son parte del programa llamado “AI Creator”, en donde influencers y creadores de contenido pueden ofrecerse como protagonistas de estos videos generados artificialmente y ganar dinero por ello, simplemente filmando unos clips de minutos de duración y enviándolos a la plataforma.

Y si bien este tipo de videos conformaría una violación a los Términos y Condiciones de la aplicación, esto también debe ser un aprendizaje para creadores de contenido que estén considerando inscribirse en este tipo de programas remunerados.

En tiempos de desinformación de fácil llegada, es vital poder reconocer este tipo de engaños o publicidades infundadas. Por eso, debemos buscar señales de que se trata de un contenido falsificado y engañoso en los siguientes puntos:

– Desincronización de la boca y labios, que no coinciden del todo con el audio.

– Expresiones faciales poco naturales o rígidas.

– Artefactos visuales y distorsiones, como bordes borrosos o cambios repentinos de iluminación.

– Voz robótica, artificial o con entonación demasiado uniforme.

– Cuentas de reciente creación, con pocos seguidores o sin historial relevante.

– Lenguaje exagerado, con frases como “cura milagrosa”, “los doctores no quieren que lo sepas” o “100% garantizado”.

– Afirmaciones que no tienen respaldo científico, o que se basan en estudios o fuentes de poca reputación.

– Llamado a la urgencia y presión para comprar en frases como “solo por tiempo limitado” o “pocas unidades disponibles”.

Si encontramos este tipo de contenidos, es vital no compartir o creer antes de verificar el origen o propósito de las afirmaciones de los videos. Además, y en el caso de identificar un contenido engañoso, debemos denunciar la publicación ante la red social que estemos usando.

Fuente: www.welivesecurity.com