Cómo verificar la autenticidad y el origen de fotografías y vídeos

Cómo diferenciar una fotografía o un vídeo real de una falsificación y rastrear su procedencia.

Durante los últimos 18 meses, más o menos, parece que hemos perdido la capacidad de confiar en nuestros ojos. Las falsificaciones de Photoshop no son nada nuevo, por supuesto, pero la llegada de la inteligencia artificial (IA) generativa ha llevado la falsificación a un nivel completamente nuevo. Quizás la primera falsificación de IA viral fue la imagen del Papa en 2023 con una chaqueta acolchada blanca de diseño, pero, desde entonces, el número de engaños visuales de alta calidad se ha disparado a muchos miles. Y, a medida que la IA se desarrolle aún más, podemos esperar más y más vídeos falsos convincentes en un futuro muy cercano.

Uno de los primeros deepfakes en hacerse viral en todo el mundo: el Papa luciendo una moderna chaqueta acolchada blanca.

Esto solo exacerbará el ya complicado problema de las noticias falsas y las imágenes que las acompañan. Pueden publicar una foto de un evento y afirmar que es de otro, poner a personas que nunca se han conocido en la misma fotografía, entre otras cosas.

La falsificación de imágenes y vídeos tiene una relación directa con la ciberseguridad. Los estafadores han estado utilizando imágenes y vídeos falsos para engañar a las víctimas y lograr que desembolsen su dinero durante años. Es posible que te envíen una fotografía de un cachorro triste que, según dicen, necesita ayuda, una imagen de una celebridad que promueve algunos planes sospechosos o, incluso, una fotografía de una tarjeta de crédito que dicen que pertenece a alguien que tú conoces. Los estafadores también utilizan imágenes generadas por IA para los perfiles falsos en sitios de citas y redes sociales.

Las estafas más sofisticadas hacen uso de vídeos y audios falsos del jefe de la víctima o de un familiar para que cumplan con las peticiones de los estafadores. Recientemente, un empleado de una institución financiera fue engañado para que transfiriera 25 millones de dólares a ciberdelincuentes. Habían pactado una videollamada con el “director financiero” y los “colegas” de la víctima, todos deepfakes.

Entonces, ¿qué se puede hacer para lidiar con los deepfakes o con las falsificaciones clásicas? ¿Cómo se pueden detectar? Este es un problema extremadamente complejo, pero que se puede mitigar paso a paso, rastreando la procedencia de la imagen.

Espera… ¿no lo había visto antes?

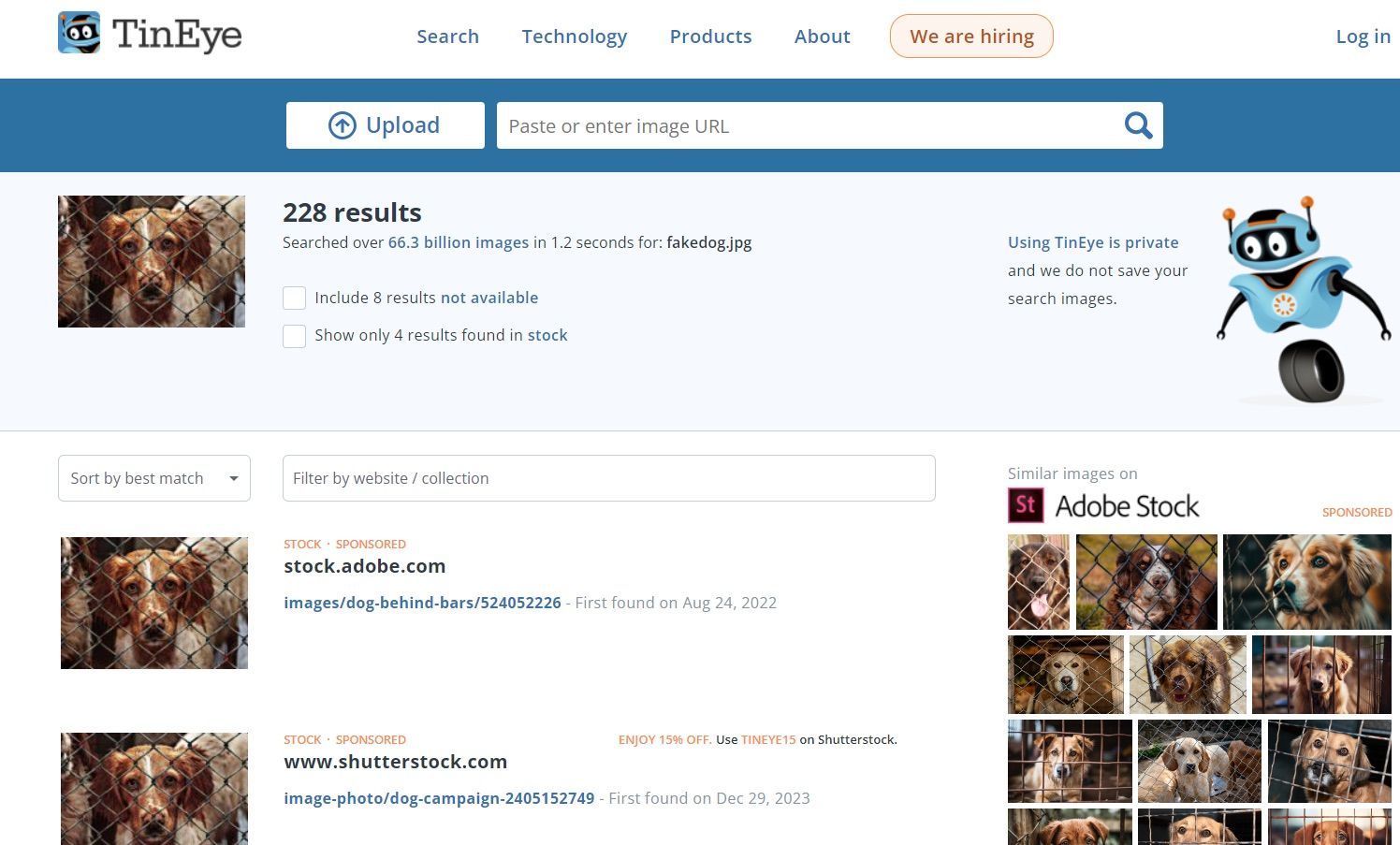

Como se mencionó anteriormente, existen diferentes tipos de “falsificaciones”. A veces, la imagen en sí no es falsa, pero se usa de manera engañosa. Tal vez una fotografía real de una zona de guerra se hace pasar como si fuera de otro conflicto, o una escena de una película se presenta como metraje documental. En estos casos, buscar anomalías en la imagen en sí no ayudará mucho, pero puedes intentar buscar copias de la fotografía en línea. Afortunadamente, tenemos herramientas como la búsqueda inversa de imágenes en Google y TinEye, que pueden ayudarnos a hacer precisamente eso.

Si tienes alguna duda sobre una imagen, simplemente cárgala en una de estas herramientas y mira los resultados. Es posible que descubras que la misma fotografía de una familia que se quedó sin hogar por el fuego, o un grupo de perros en un refugio, o las víctimas de alguna otra tragedia, ha estado circulando en línea durante años. Por cierto, cuando se trata de una recaudación de fondos falsa, hay algunas otras señales de alerta a tener en cuenta además de las imágenes en sí.

¿Perro de un refugio? No, de un stock de fotografías.

¿Se usó Photoshop? Pronto lo sabremos.

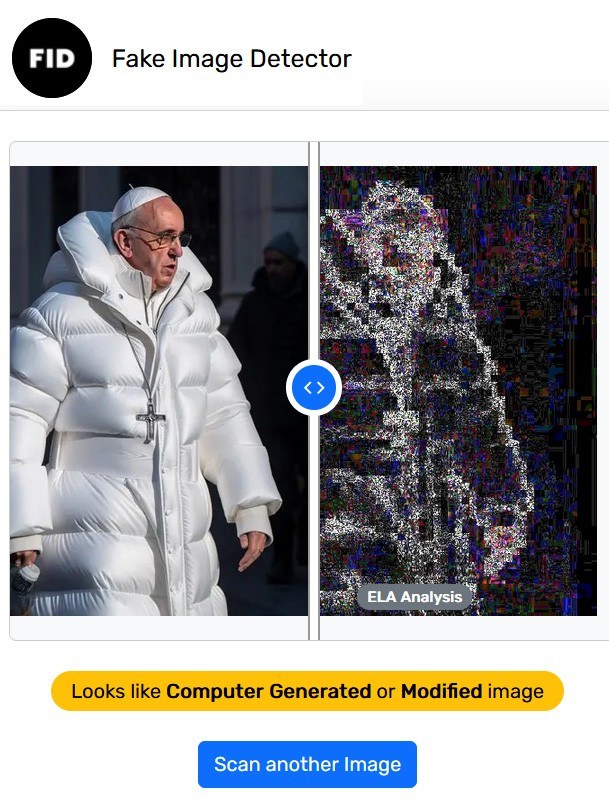

Dado que la edición en Photoshop existe desde hace un tiempo, los matemáticos, los ingenieros y los expertos en imágenes han estado trabajando durante mucho tiempo en formas para detectar imágenes alteradas automáticamente. Algunos métodos populares incluyen el análisis de metadatos de imágenes y el análisis de nivel de error (ELA), que comprueba si hay artefactos de compresión JPEG para identificar las partes modificadas de una imagen. Muchas herramientas de análisis de imágenes populares, como Fake Image Detector, aplican estas técnicas.

Fake Image Detector advierte que el Papa probablemente no usó esa campera el domingo de Pascuas… o nunca.

Con la aparición de la IA generativa, también hemos visto nuevos métodos basados en la IA para detectar el contenido generado, pero ninguno de ellos es perfecto. Estos son algunos de los desarrollos relevantes: detección de cambio de rostro, detección de imágenes generadas por IA y determinación del modelo de IA utilizado para generarlas, y un modelo de IA abierto para los mismos fines.

Con todos estos enfoques, el problema clave es que ninguno te da el 100 % de certeza sobre la procedencia de la imagen, garantiza que la imagen esté libre de modificaciones o permite verificar dichas modificaciones.

WWW al rescate: verificar la procedencia del contenido

¿No sería fantástico si los usuarios comunes pudieran comprobar si una imagen es real? Imagina hacer clic en una fotografía y ver algo como: “John tomó esta fotografía con un iPhone el 20 de marzo”, “Ann recortó los bordes y aumentó el brillo el 22 de marzo”, “Peter volvió a guardar esta imagen con alta compresión el 23 de marzo”, o ” No se realizaron cambios”, y todos estos datos serían imposibles de falsificar. Suena como un sueño, ¿cierto? Bueno, eso es exactamente lo que busca la Coalición para la Procedencia y Autenticidad del Contenido (C2PA). La C2PA incluye algunos de los principales actores de las industrias de la informática, la fotografía y los medios de comunicación: Canon, Nikon, Sony, Adobe, AWS, Microsoft, Google, Intel, BBC, Associated Press y alrededor de un centenar de otros miembros; básicamente todas las empresas que podrían haber estado involucradas individualmente en casi cualquier paso de la vida de una imagen, desde su creación hasta su publicación en línea.

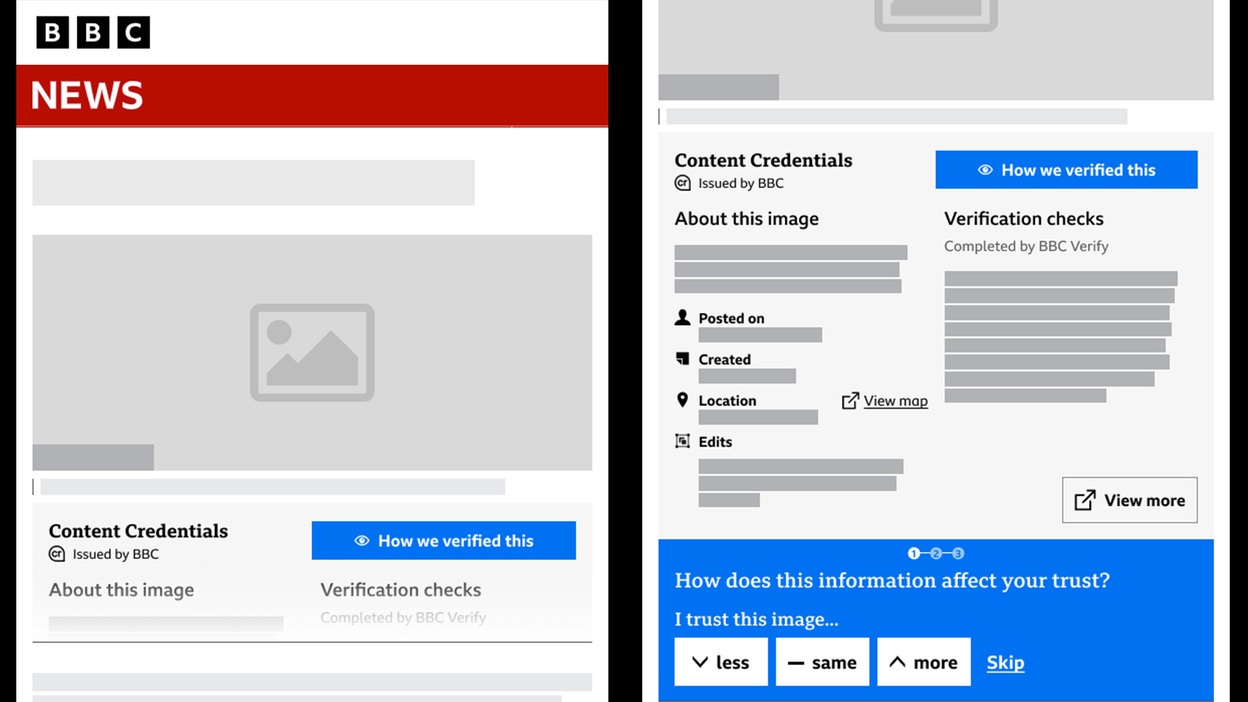

El estándar de la C2PA desarrollado por esta coalición ya está disponible e incluso ha alcanzado la versión 1.3, y ahora estamos empezando a ver que las piezas del rompecabezas industrial necesarias para usarlo encajan en su lugar. Nikon planea fabricar cámaras compatibles con la C2PA, y la BBC ya ha publicado sus primeros artículos con imágenes verificadas.

La BBC habla sobre cómo se verifican las imágenes y los vídeos en sus artículos.

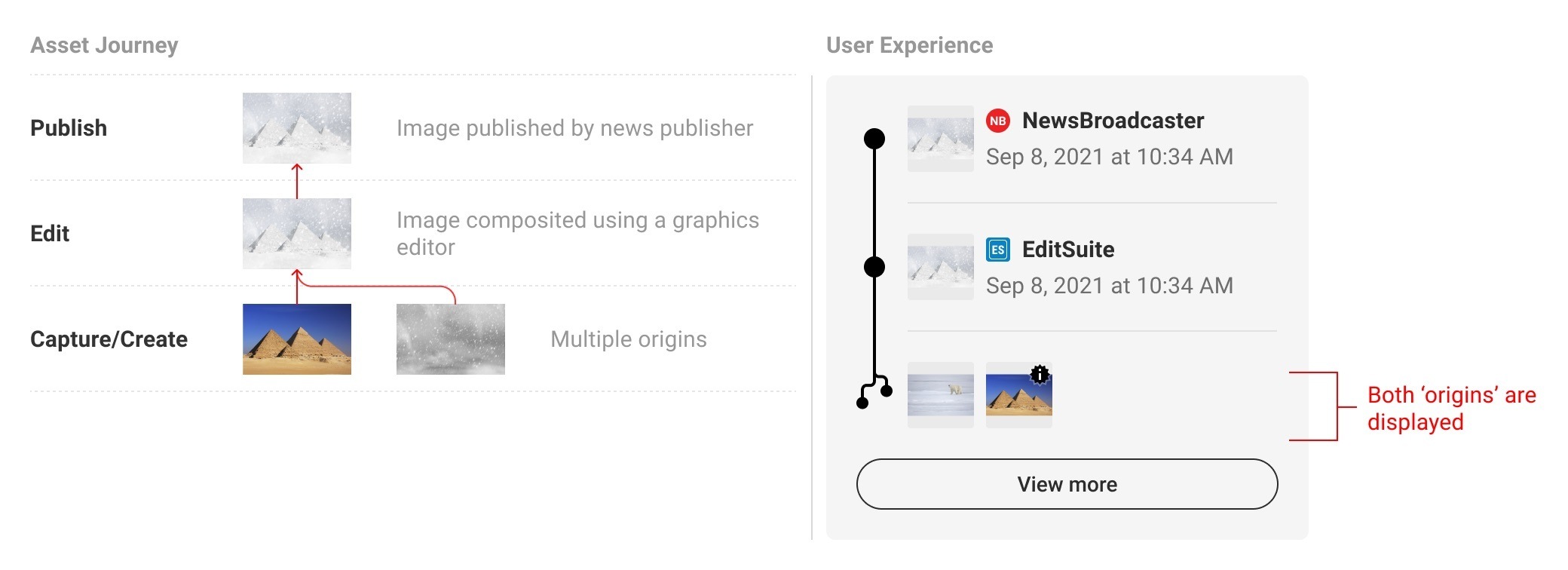

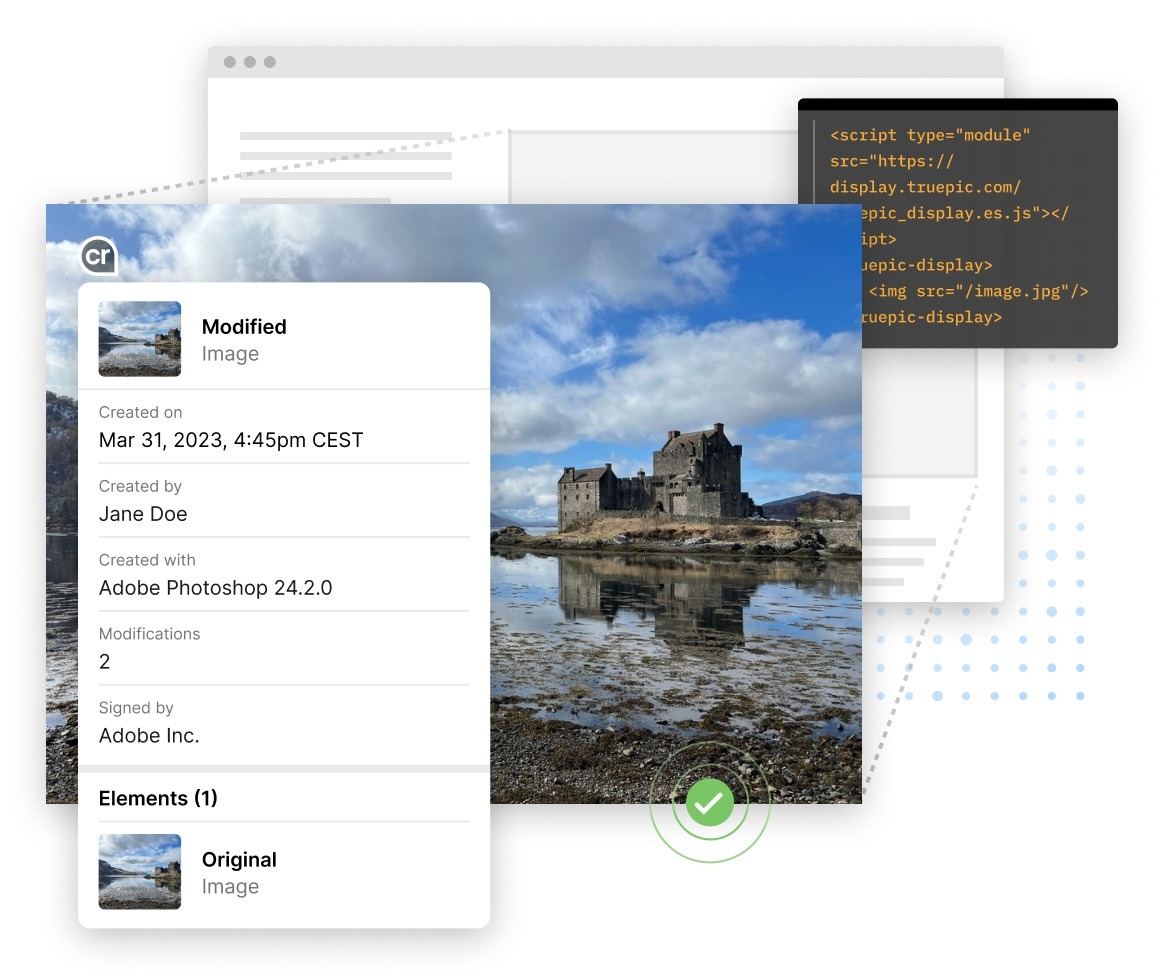

La idea es que, cuando los medios de comunicación responsables y las grandes empresas pasen a publicar imágenes en forma verificada, puedas comprobar la procedencia de cualquier imagen directamente en el navegador. Verás una pequeña etiqueta de “imagen verificada” y, cuando hagas clic en ella, aparecerá una ventana más grande que te mostrará qué imágenes sirvieron como origen y qué ediciones se realizaron en cada etapa antes de que la imagen apareciera en el navegador, quién las hizo y cuándo. Incluso podrás ver todas las versiones intermedias de la imagen.

Historia de la creación y edición de imágenes.

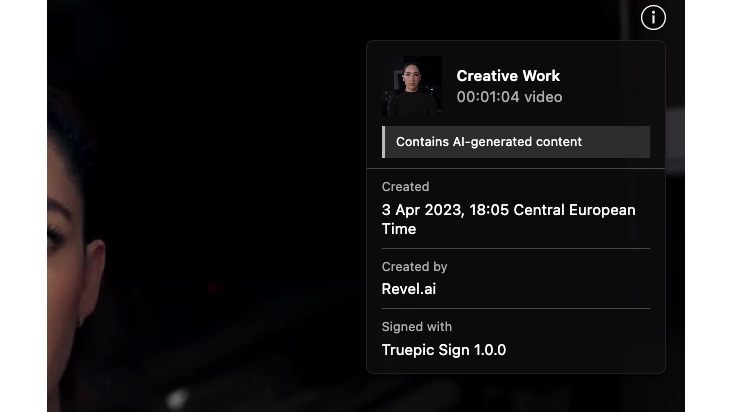

Este enfoque no es solo para cámaras; también puede funcionar para otras formas de crear imágenes. Servicios como Dall-E y Midjourney también pueden etiquetar sus creaciones.

Esto fue claramente creado en Adobe Photoshop.

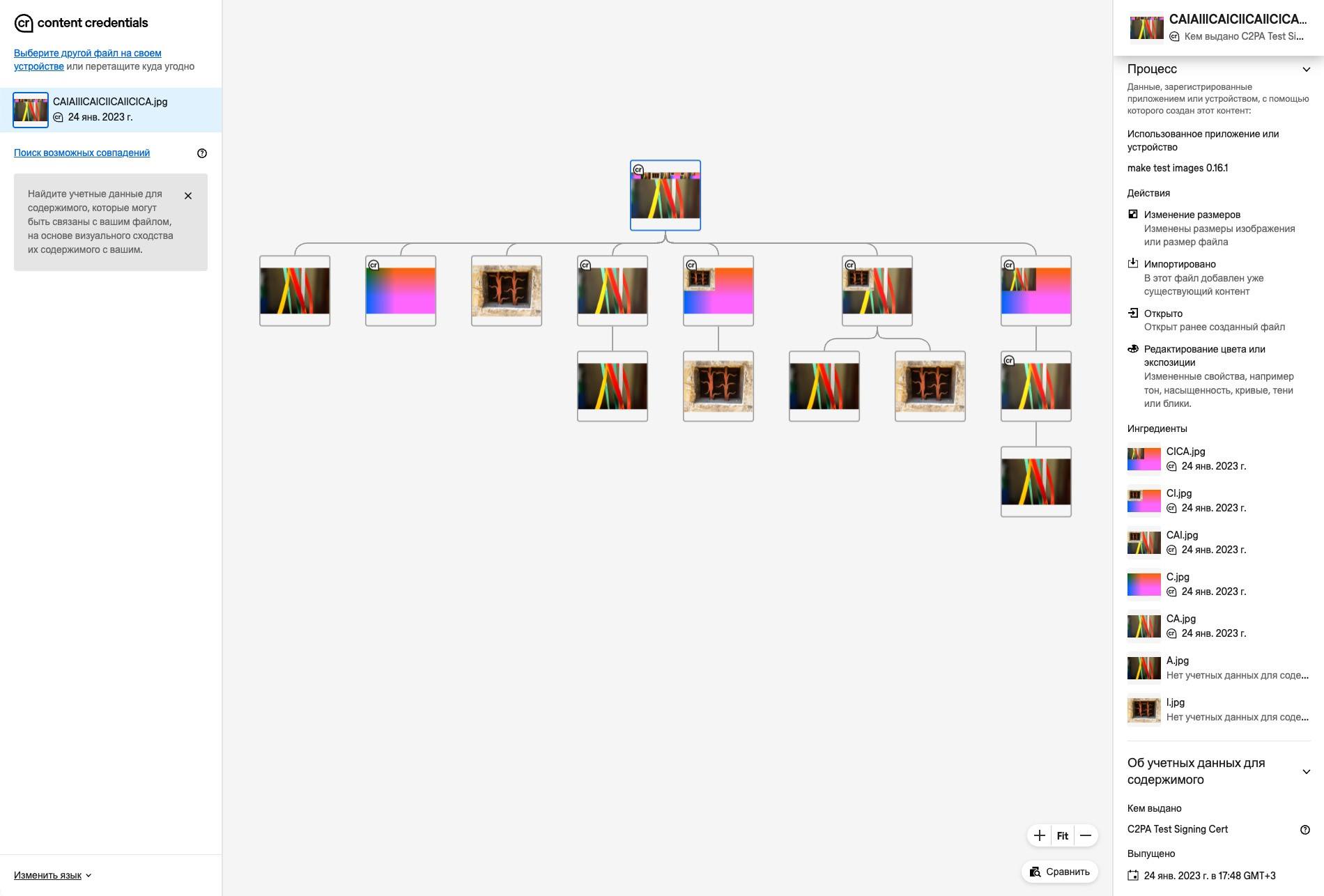

El proceso de verificación se basa en una criptografía de clave pública similar a la protección utilizada en los certificados de servidor web para establecer una conexión HTTPS segura. La idea es que cada creador de imágenes, ya sea Joe Bloggs con un tipo particular de cámara o Angela Smith con una licencia de Photoshop, necesitará obtener un certificado X.509 de una autoridad de certificación de confianza. Este certificado se puede conectar directamente a la cámara en la fábrica, mientras que, para los productos de software, se puede emitir al momento de la activación. Al procesar imágenes con seguimiento de procedencia, cada nueva versión del archivo contendrá una gran cantidad de información adicional: la fecha, hora y ubicación de las ediciones, las miniaturas de las versiones original y editada, etc. Todo esto irá firmado digitalmente por el autor o editor de la imagen. De esta forma, un archivo de imagen verificado tendrá una cadena de todas sus versiones anteriores, cada una firmada por la persona que lo editó.

Este vídeo incluye contenido generado por IA.

Los autores de la especificación también se preocuparon por las funciones de privacidad. A veces, los periodistas no pueden revelar sus fuentes. Para situaciones como esa, hay un tipo especial de edición llamada “redacción”. Esto permite que alguien reemplace parte de la información sobre el creador de la imagen con ceros y luego firme ese cambio con su propio certificado.

Para mostrar las capacidades de la C2PA, se creó una colección de imágenes y vídeos de prueba. Puedes consultar el sitio web de Content Credentials para ver las credenciales, el historial de creación y el historial de edición de estas imágenes.

El sitio web de Content Credentials revela el origen completo de las imágenes de la C2PA.

Limitaciones naturales

Desafortunadamente, las firmas digitales para imágenes no resolverán el problema de las falsificaciones de la noche a la mañana. Después de todo, ya hay miles de millones de imágenes en línea que no han sido firmadas por nadie y que no van a ninguna parte. Sin embargo, a medida que más y más fuentes de información de renombre pasen a publicar solo imágenes firmadas, cualquier fotografía sin una firma digital comenzará a ser vista con sospecha. Las fotografías y los vídeos reales con marcas de tiempo y datos de ubicación serán casi imposibles de hacer pasar por otra cosa, y el contenido generado por IA será más fácil de detectar.

Fuente: latam.kaspersky.com