La Comisión Federal de Comunicaciones de Estados Unidos (FCC) acaba de votar con un 3 a 2 acabar con las normas que protegen la neutralidad de la red, y que permiten que todos los servicios compitan en igualdad de condiciones. Se trata de la puesta en marcha de un plan presentado por Ajit Pai, presidente del organismo.

Esta decisión hará que Estados Unidos de un importante paso atrás en materia de libertades de la red. Y de paso normalizarán una situación que podría dar pie a que en otros sitios como Europa las cosas también empezasen a cambiar, y al final todos los usuarios suframos las consecuencias de esta decisión.

Un paso para adelante, dos para atrás

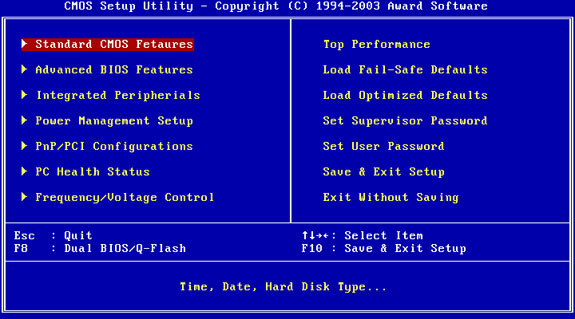

Hace tres años la situación era bastante parecida en Estados Unidos, y en mayo del 2014 la FCC había votado a favor de seguir con un plan para crear un Internet de dos velocidades. El futuro de la neutralidad pintaba muy oscuro, pero todo acabó dando un giro de 180 grados al surgir otra propuesta totalmente opuesta que acabó imponiéndose en 2015.

Con ella se estableció que Internet pasase un servicio básico como la electricidad y el agua, y obligaba a los operadoras a garantizar un acceso igualitario. Se trató por lo tanto de una legislación atrevida que llegó cuando menos se esperaba, y que supuso un ejemplo a seguir para el resto de países. De hecho, algunos países europeos ya se habían posicionado a favor del Internet de dos velocidades, y finalmente la Unión Europea también acabó legislando para proteger la neutralidad.

Pero la normativa europea no es lo suficientemente rotunda, y deja la puerta abierta a que cada país tenga el poder de decidir sobre el zero-rating. Eso ha provocado que operadoras como Orange, Vodafone o FreedomPop hayan sacado tarifas en las que el tráfico de determinadas aplicaciones tiene más privilegios que el de otras.

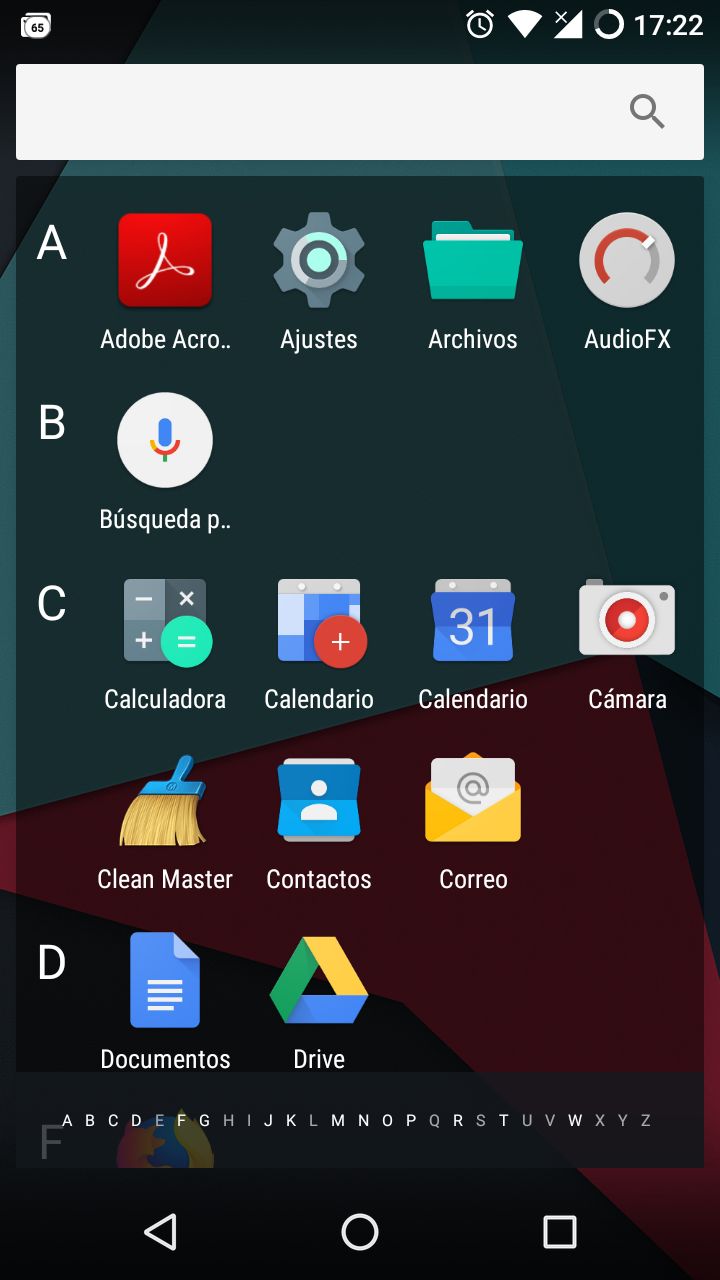

Estados Unidos seguía siendo por lo tanto el espejo en el que mirarse, un referente. Aunque todo empezó a cambiar este año con la aparición de Ajit Pai, que desde su puesto de la presidencia de la FCC decidió dar marcha atrás y cargarse la neutralidad. Con ello las operadoras podrán decidir qué aplicaciones tienen más privilegios que otras.

Organizaciones de usuarios, empresas, e incluso algunos miembros de la FCC se han posicionado en contra de esta situación, pero el organismo no ha dudado en utilizar botnets para aparentar un falso apoyo. Por si fuera poco, el propio Ajit Pai ha publicado un vídeo burlándose de la neutralidad de la red para desinformar a los usuarios tratando de hacerles creer que nada va a cambiar.

Qué cambia con la ley aprobada hoy

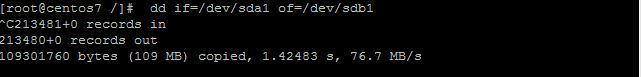

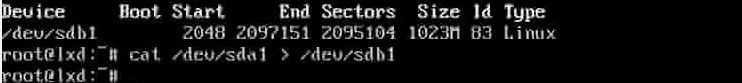

Pero las cosas sí van a cambiar. Para empezar, los primeros perjudicados por la aniquilación de la neutralidad en Estados Unidos serán los propios usuarios estadounidenses. Hoy Internet deja de ser considerado un servicio básico como la electricidad y el agua, y deja de garantizarse un acceso igualitario como se estaba haciendo desde que se aprobaron las últimas normas.

Esto pone en manos de las operadoras el poder hacer prácticamente lo que quieran. Pueden bloquear el acceso a determinados servicios, acelerar la velocidad a la que se accede a otros, o incluso priorizar el contenido que quieran. La única condición que tienen que cumplir es hacer públicos estos cambios.

Así será más difícil que los servicios de terceros puedan competir en igualdad de condiciones. También abre la puerta a que las propias operadoras puedan utilizar este poder para priorizar sus propios servicios penalizando otras aplicaciones sin que ni estas ni los usuarios puedan impedirlo.¡

Esto a la larga podrá acabar provocando que los propios servicios tengan que negociar con las operadoras para que sus usuarios puedan acceder correctamente a ellos, lo que hará que los que no tengan los suficientes recursos queden desterrados del Internet de alta velocidad y vean lastrada su adopción y su futuro.

Así nos afecta a los demás

En Europa tenemos nuestras propias leyes y lógicamente no se aplican directamente las de EEUU. Sin embargo, muchos de los servicios que utilizamos son de Estados Unidos o tienen gran parte de sus usuarios allí, desde Facebook hasta la propia Google pasando por muchos otros servicios de menor potencia. Por eso, lo que hagan las operadoras en aquel país puede perjudicarles y repercutir en cómo funcionan a nivel técnico o económico en todo el mundo.

También hay que tener en cuenta que las nuevas normas dañan la competencia entre servicios. Con las operadoras al poder, muchos servicios tendrán que negociar para conseguir funcionar correctamente para muchos usuarios. Esto perjudicará posiblemente a todos los que empiezan o ya compiten contra los más grandes. Y al final esto hace que todos tengamos menos libertad de elección independientemente de si somos de EE.UU. o de fuera.

El que los servicios tengan que negociar con las operadoras para obtener un trato favorable también constituye otro problema para todos. Muchos servicios no querrán perder dinero, por lo que al final lo que ellos tengan que pagarles a las operadoras lo acabaremos pagando también todos los consumidores.

Y esperemos que las operadoras europeas y la UE no tomen ahora nota y quieran imitar a sus homólogos estadounidenses. Porque ese es otro de los peligros de la decisión que se ha tomado hoy allí, que haga que otros países en todo el mundo acaben cediendo a las presiones del lobby de las operadoras y tomando decisiones parecidas.

Fuente: www.linux-party.com